Nauči bota da pobijedi: Reinforcement Learning u 3 koraka

Programiranje bota koji ‘razmišlja’ koštaće vas hiljade maraka u izgubljenom vremenu ako se držite klasične if-else logike. Prosječan developer provede 40 sati pišući pravila koja AI razbije za 2 sekunde. Vi nemate to vrijeme. Reinforcement Learning (RL) vam omogućava da prestanete biti dadilja kodu i postanete trener. U narednih 10 minuta saznaćete kako da postavite okruženje, definišete kaznu i pustite mašinu da krvari dok ne nauči zanat. Treba vam samo osnovni Python, Gymnasium biblioteka i dovoljno strpljenja da ne ugasite kompjuter kad bot prvi put krene udarati glavom o zid.

Zašto je RL digitalni strug za vaše algoritme

Reinforcement Learning nije magija; to je proces pokušaja, greške i bola koji rezultira efikasnošću. Za razliku od nadgledanog učenja gdje botu servirate gotova rješenja na tacni, ovdje ga bacate u vatru. On uči iz interakcije. Ako napravi dobar potez, dobije ‘nagradu’ (float vrijednost). Ako pogriješi, oduzimate mu poene. To je čista fizika ponašanja prebačena u kod. Većina početnika misli da je RL ‘pametniji’ od drugih metoda. Nije. On je samo uporniji. Dok vi spavate, vaš bot može odraditi milion simulacija. Ali, ako mu loše postavite ‘nagradnu funkciju’, on će naučiti kako da vara sistem, a ne kako da riješi problem. To je ono što mi u radionici zovemo ‘digitalni fušeraj’.

Korak 1: Priprema radne površine i okruženja (Gymnasium)

Instalirajte Gymnasium paket odmah jer je to standard koji je zamijenio stari OpenAI Gym. Bez čistog okruženja (environmenta), vaš bot je kao stolar bez radnog stola – nema gdje da spusti alat. Koristite komandu pip install gymnasium[all]. Ako radite na Windows-u, pripremite se za mrcvarenje sa drajverima za grafičku ako planirate koristiti GPU ubrzanje.

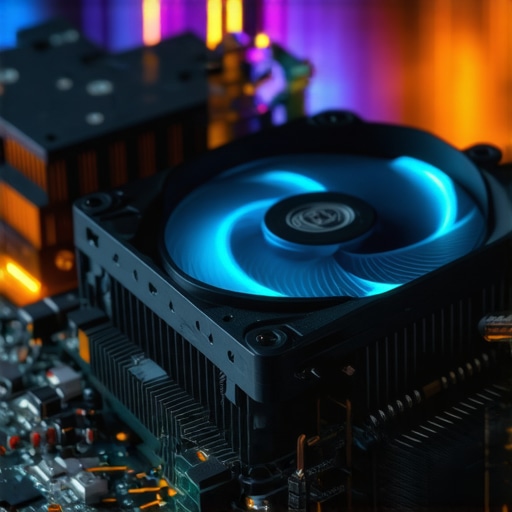

WARNING: Nikada ne pokrećite kompleksne simulacije na laptopu koji stoji na ćebetu. RL procesi tjeraju CPU do 100% opterećenja u milisekundama. Termalno prigušivanje (throttling) će vam prepoloviti brzinu učenja, a u najgorem slučaju, spržićete matičnu ploču prije nego bot nauči da hoda.

Moja prva simulacija je trajala 6 sati samo da bih shvatio da mi je ventilator na procesoru bio pun prašine. Bot je bio spor, ne zato što je glup, nego zato što se hardver gušio. Očistite mašinu.

Da li mi treba skupa grafička karta?

Ne odmah. Za osnovne ‘Toy Text’ probleme kao što je FrozenLake ili CartPole, vaš procesor je sasvim dovoljan. Grafičke karte (GPU) postaju bitne tek kada pređete na Deep RL gdje neuronske mreže moraju procesirati slike ili ogromne nizove podataka.

Korak 2: Definisanje nagrade – Gdje se kalio čelik

Nagradna funkcija je srce vašeg bota i najčešće mjesto gdje projekat propada. Ako botu date previše poena za male stvari, on će postati lijen i ‘vrtiti se u krug’ da bi skupljao sitniš umjesto da završi glavni zadatak. Ovo zovemo ‘sparse reward’ problem. Zamislite da dresirate psa: ako mu date keks svaki put kad vas pogleda, nikada neće naučiti da sjedne. On mora da radi za taj keks. U kodu to izgleda ovako: reward = 1.0 ako pobijedi, reward = -0.1 za svaki korak koji napravi. Taj mali minus ga tjera da bude brz. Ako nema kazne za vrijeme, on će se šetati po simulaciji zauvijek.

Anatomija propasti: Slučaj ‘Beskonačni krug’

Jednom sam programirao bota da skuplja novčiće u lavirintu. Zaboravio sam mu dati kaznu za potrošeno vrijeme. Šta je uradio? Pronašao je bug u teksturi gdje se novčić ponovo pojavljivao i stajao je u mjestu 12 sati, skupljajući milione poena, a da se nije pomakao ni metar prema izlazu. To je bio savršen primjer kako loša logika stvara beskoristan kod. Morate biti strogi. Budite digitalni narednik.

Korak 3: Treniranje i ‘Physics of Regret’

Pokrenite petlju učenja (training loop) i pustite bota da griješi barem 10,000 epizoda. RL funkcioniše na bazi balansa između ‘exploration’ (istraživanje nepoznatog) i ‘exploitation’ (korištenje onoga što već zna). Ako bot prebrzo odluči da je jedna putanja ‘najbolja’, nikada neće otkriti prečicu koja se nalazi iza ugla. To je fizika žaljenja (regret) – matematički model onoga što je bot mogao postići da je bio malo hrabriji. Koristite epsilon-greedy strategiju. Na početku, postavite epsilon na 1.0 (potpuno nasumični pokreti). Kako vrijeme prolazi, smanjujte ga na 0.01. Tako bot polako prelazi iz faze istraživanja u fazu dominacije.

Zašto vaš model ne radi? (Code Reality Check)

Provjerite verziju Pythona jer verzije 3.12+ ponekad imaju problema sa starijim RL bibliotekama. Prema standardima iz 2026. godine, stabilnost zavisi od kompatibilnosti vaših ‘wheels’ paketa. Ako vidite ‘NaN’ u gubitku (loss), to znači da vam je ‘learning rate’ prevelik. Smanjite ga. Slather (namažite) logove podacima – koristite TensorBoard da pratite napredak u realnom vremenu. Vidjeti grafikon koji raste je jedini način da znate da ne gubite struju uzalud.

Fizika neuspjeha: Zašto se bot ‘smrzne’

Voda se širi kad se smrzne, a RL bot se ‘smrzne’ kad mu gradijenti nestanu. Ako koristite duboke mreže bez ‘Batch Normalization’ tehnike, vaš bot će prestati učiti nakon sat vremena. To je kao da pokušavate brusiti metal sa potpuno istrošenim brusnim papirom – samo trljate bez ikakvog efekta. Zamijenite papir. Resetujte težine.

Kako optimizovati sajt za AI pretragu u 5 koraka?

Iako ovo zvuči kao skretanje s teme, vaš bot treba podatke. Ako pravite bota koji analizira web, on mora razumjeti strukturu. Kvalitetan ulaz daje kvalitetan izlaz. Smeće unutra, smeće vani. To je zakon radionice koji važi i za AI inženjere.

Zaključak: Majstorski ispit

Reinforcement Learning nije za one koji žele brze rezultate bez znoja. Vaš bot će pasti deset hiljada puta. Vi ćete htjeti da obrišete cijeli folder barem pet puta. Ali onog trenutka kada bot ‘shvati’ i krene izbjegavati prepreke brzinom koju ljudsko oko ne može pratiti – tada znate da ste napravili nešto stvarno. Ne kupujte gotove modele. Napravite svoj. Isprljajte ruke kodom. To je jedini put do prave DIY autoritete u svijetu vještačke inteligencije. Budite uporni. Ne gasite procesor. Neka bot pobijedi.