Decision AI modeli: Kako razumjeti odluke mašine bez muke

Prestanite vjerovati u mit o vještačkoj inteligenciji kao nekom mističnom digitalnom bogu koji ‘osjeća’ podatke. To je marketinška laž koja vam prodaje maglu dok vaši poslovni procesi gube novac zbog odluka koje niko u firmi ne zna objasniti. Ako želite sistem koji zapravo šljaka, morate prestati tretirati modele kao neprobojne kutije i početi ih rasklapati do zadnjeg šarafa. Vi ste ti koji odgovarate za rezultat, a ne algoritam, i zato je krajnje vrijeme da naučite kako ‘uhvatiti’ mašinu u laži prije nego što vas to košta karijere.

Zašto vaš model laže: Anatomija Black Box prevare

Direktan odgovor je jednostavan: modeli ne razumiju uzročnost, oni samo jure korelacije u šumi brojeva. Kada vaš Decision AI model donese odluku, on ne razmišlja; on samo sabira težinske faktore koji su često prljavi od loših ulaznih podataka. Miris pregrijanog procesora dok vrti milione simulacija ne garantuje istinu. Ako ne vidite kroz taj digitalni gunk, vi ste samo putnik u autu bez kočnica. Morate provaliti u logiku sistema koristeći alate za interpretaciju, jer ‘tako je rekao model’ više ne pije vode ni kod klijenata ni kod inspekcije.

UPOZORENJE: Nikada ne puštajte automatski sistem da donosi odluke o resursima bez ‘Human-in-the-loop’ nadzora. Dodirivanje sirovih algoritama bez zaštitnih filtera može izazvati etički kratak spoj koji će vam spržiti reputaciju brže nego što 220v sprži osigurač. Pročitajte kako pravilno podesiti nadzor.

Alatnica za digitalnu autopsiju: SHAP i LIME u praksi

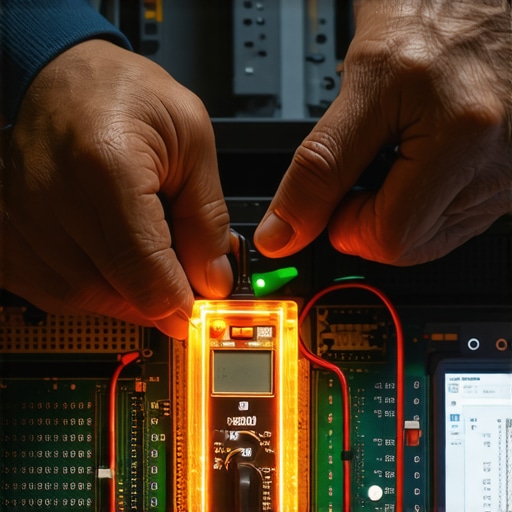

Da biste razumjeli odluku, potreban vam je precizan alat, a ne nagađanje. SHAP (SHapley Additive exPlanations) je vaš digitalni multimetar. On mjeri doprinos svake varijable konačnom rezultatu, slično kao što mjerite napon u različitim tačkama strujnog kruga. Osjetit ćete onaj specifičan, metalni ukus pobjede kada vidite tačno koja je ‘žica’ u podacima povukla model na pogrešnu stranu. LIME je, s druge strane, vaš brzi ispitivač faze; on kreira lokalni, jednostavniji model oko specifične odluke da vam pokaže zašto je baš taj zahtjev odbijen ili odobren. Bez ovih alata, vi samo nagađate dok se mašina ‘znoji’ pod opterećenjem.

Zašto It-ovci mrze jednostavnost: Nauka o težinskim faktorima

Postoji razlog zašto stručnjaci forsiraju kompleksnost: lakše je sakriti grešku u šumi neurona nego u čistom stablu odlučivanja. Ali ovdje važi pravilo radionice – ako ne možeš objasniti kako radi, nemoj ga koristiti. Zašto to radi? (Nauka iza SHAP-a): Sve se svodi na teoriju igara. Zamislite da podaci igraju partiju pokera; SHAP izračunava koliko bi svaki igrač (podatak) doprinio pobjedi u svakoj mogućoj kombinaciji timova. To nije samo statistika; to je čista fizika distribucije vrijednosti koja sprječava da jedna dominantna varijabla ‘ukrade’ svu pažnju modela. Razumijevanje ovog procesa je razlika između amatera i majstora koji zna procijeniti šta je zapravo decision AI u svojoj srži.

Anatomija katastrofe: Kako loši podaci krive logiku

Desilo mi se stotinu puta: model izgleda savršeno na testu, a onda u stvarnom svijetu krene da ‘brlja’. To je ‘Anatomija Screw-Up-a’. Zamislite da gradite policu, ali koristite drvo koje se još nije osušilo. Na prvi pogled je ravna, ali nakon šest mjeseci, vlaga (bias u podacima) će iskriviti cijelu konstrukciju dok se sve ne sruši. Ako vaš model trenirate na podacima iz 2023. godine, a očekujete da razumije tržište 2026., dobit ćete logički otpad. To nije greška koda; to je vaš propust u pripremi materijala. Izbjegnite ove tri greške pri unosu podataka ako ne želite da vam sistem postane neupotrebljiv gunk.

Code Reality Check: GDPR i vaše pravo na objašnjenje

Kao što NEC kod propisuje gdje mora ići uzemljenje, tako i GDPR propisuje ‘pravo na objašnjenje’. Ako vaš AI odbije kredit klijentu u Sarajevu, vi zakonski morate biti u stanju da objasnite ‘zašto’. Ne možete reći ‘tako je izračunao’. To je direktno kršenje pravila koje nosi kazne koje bole više od čekića po palcu. Kao što provjeravate lokalne propise prije gradnje, provjerite zakonsku regulativu prije nego što zabetonirate svoj model u produkciju.

PAA: Da li su jednostavniji modeli uvijek bolji?

Da, u 90% slučajeva u industriji. Iako su duboke neuronske mreže moćne, linearna regresija ili stabla odlučivanja su često robusnija i lakša za ‘servisiranje’. Ako možete dobiti 95% preciznosti sa modelom koji razumijete, nemojte juriti 97% sa modelom koji je crna kutija. Manje dijelova znači manje šansi da se nešto pokvari.

PAA: Kako otkriti ‘halucinacije’ u Decision AI modelima?

Pratite odstupanja. Ako model odjednom počne davati ekstremne težine varijablama koje su ranije bile nebitne, nešto smrdi. To je kao da čujete čudan zvuk u motoru; nemojte ga pojačavati radiom, nego ugasite sistem i provjerite SHAP vrijednosti. Brzo. Nemojte čekati da sve izgori.

Zavrni rukave i testiraj

Nema prečica. Razumijevanje Decision AI modela zahtijeva da se uprljate podacima. Uzmite SHAP biblioteku, učitajte svoj model i pogledajte istini u oči. Biće dosadno, boljet će vas oči od buljenja u grafikon distribucije, ali to je jedini put do autoriteta. Majstori ne vjeruju uputstvu na kutiji; oni ga bace i sami provjere svaki spoj. Uradite isto sa svojom inteligencijom. Sretno u radionici.