Ne kvari rezultate: 3 greške kod normalizacije podataka [ML]

Prestanite slijepo vjerovati automatizovanim alatima za skaliranje podataka. Većina ‘stručnjaka’ na internetu će vam reći da samo ‘provučete’ podatke kroz StandardScaler i problem je riješen. To je laž koja će vas koštati preciznosti modela i sati bespotrebnog debugginga. Ako ne razumijete hemiju svojih podataka, vi niste inženjer mašinskog učenja, vi ste samo neko ko prepisuje tuđe greške. Vaši podaci imaju teksturu, miris i otpor, baš kao komad sirovog hrasta u radionici. Ako ih tretirate pogrešno, oni će puknuti pod pritiskom produkcije.

Prva greška: Curenje informacija ili kako si prosuo ulje po čistom podu

Prva i najsmrtonosnija greška koju početnici prave je normalizacija cijelog dataseta prije nego što urade ‘train-test split’. Ovo je ekvivalentno tome da vidite pitanja na testu prije nego što počnete učiti. Kada izračunate srednju vrijednost i standardnu devijaciju na kompletnom skupu podataka, informacije iz testnog skupa cure u trenažni proces. Vaš model ‘osjeća’ raspodjelu podataka koje teoretski nikada ne bi smio vidjeti. Rezultat? Lažni osjećaj uspjeha. Na papiru dobijate savršen accuracy, ali čim model pustite u rad, on se raspada kao loše zalijepljena polica. Prvo podijeli. Onda skaliraj. Uvijek.

UPOZORENJE: Curenje podataka (Data Leakage) kroz normalizaciju može dovesti do varijanse koja je nevidljiva tokom validacije, ali fatalna u produkciji. Ako tvoj

scaler.fit()vidi testne podatke, tvoj model je kompromitovan.

Zaboravljeni outlieri: Zašto tvoj Min-Max scaler liči na zahrđalu testeru

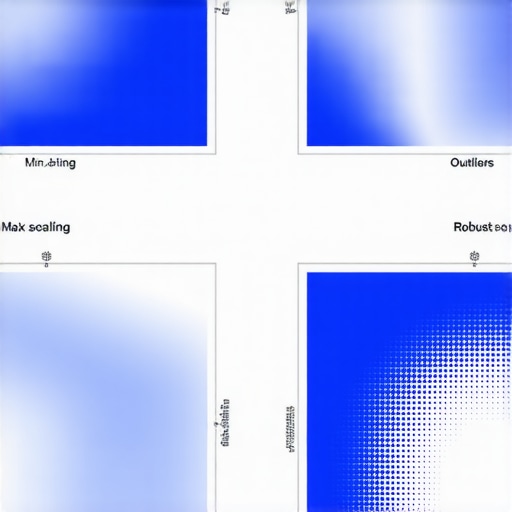

Ako vaši podaci sadrže outliere – one vrijednosti koje štrče kao ekseri iz stare daske – MinMaxScaler je najgori alat koji možete izabrati. Min-Max skaliranje stiska sve vaše podatke u opseg od 0 do 1 na osnovu apsolutnog minimuma i maksimuma. Ako imate jedan jedini unos koji je deset puta veći od ostalih, on će ‘rastegnuti’ skalu toliko da će svi ostali bitni podaci završiti zbijeni u sićušnom prostoru blizu nule. Model više ne vidi nijanse. Osjetićete frustraciju dok gledate kako vaš loss stoji u mjestu jer model bukvalno ne može razlikovati signale. Za ovakve situacije koristite RobustScaler koji koristi interkvartilni opseg. On ignoriše ‘gelere’ u podacima i fokusira se na ono što je bitno.

Da li je StandardScaler uvijek siguran izbor?

Ne. StandardScaler pretpostavlja da vaši podaci prate normalnu (Gausovu) raspodjelu. Ako su vaši podaci asimetrični, on će ih pokušati silom ugurati u kalup koji im ne odgovara. To je kao da pokušavate ugurati četvrtasti klip u okruglu rupu. Rezultat će biti iskrivljen. Uvijek prvo provjerite histogram. Ako vidite dugačak rep na jednu stranu, možda vam treba logaritamska transformacija prije nego što uopšte dodirnete scaler.

Anatomija katastrofe: Šta se desi kada zaboraviš sačuvati parametre skalera

Zamislite ovo: proveli ste vikend trenirajući model, sve radi savršeno. Pustite ga na server, stižu novi podaci, i odjednom – rezultati su totalno smeće. Zašto? Jer ste za nove podatke kreirali novi skaler umjesto da koristite onaj koji je ‘naučio’ parametre trenažnog skupa. Ovo je klasičan promašaj. Vaš model očekuje podatke koji su pomjereni i skalirani tačno onako kako je to urađeno tokom treninga. Ako novi podaci imaju drugačiji prosjek, a vi ih skalirate na osnovu njihovog sopstvenog prosjeka, brojevi koje šaljete modelu više nemaju isto značenje. Model je zbunjen. Vi ste bijesni.

Nauka o materijalima: Zašto interakcija sa nulama mijenja sve

Kada radite sa rijetkim podacima (sparse data), kao što su tekstualne reprezentacije, Standardizing ih može potpuno uništiti. Oduzimanje srednje vrijednosti od svake stavke će pretvoriti nule u ne-nule, uništavajući strukturu vaše matrice i trošeći memoriju dok server ne počne da vrišti pod opterećenjem. Za ovakve materijale koristite MaxAbsScaler. On čuva ‘prazninu’ u podacima, a ipak ih dovodi u red. To je razlika između dobrog zanatlije i amatera koji samo mlati čekićem.

Često postavljana pitanja o normalizaciji

Moram li normalizovati target varijablu?

Uglavnom ne, osim ako radite sa regresijom gdje su ciljne vrijednosti ogromne ili prate specifičnu nelinearnu distribuciju. U većini slučajeva, fokusirajte se na featurse.

Šta ako preskočim normalizaciju?

Algoritmi bazirani na udaljenosti, poput K-Nearest Neighbors ili SVM, biće potpuno beskorisni. Karakteristika sa najvećim brojevima će dominirati, čak i ako je najmanje bitna. Nemoj biti lijen.

Zašto ovo radi: Fizika iza skaliranja

Kod neuralnih mreža, normalizacija nije samo estetika; to je stvar termodinamike vašeg učenja. Kada su podaci normalizovani, gradijenti teku brže i stabilnije. Zamislite da gurate loptu niz glatku padinu umjesto kroz duboko blato. Bez normalizacije, vaš optimizator se ‘zaglavljuje’ u uskim kanjonima prostora greške. Kvalitetna normalizacija osigurava da svaka težina u mreži dobija fer šansu da uči, bez da jedna dominira nad drugom. Koristite alate pametno, provjeravajte kodove iz 2026. i ne dozvolite da vam sitne greške u pripremi sruše kulu koju ste gradili danima.