Precizno mašinsko učenje: Fix za data imbalance greške

Moja ispovijest: Kako me je 99% preciznosti zamalo koštalo posla

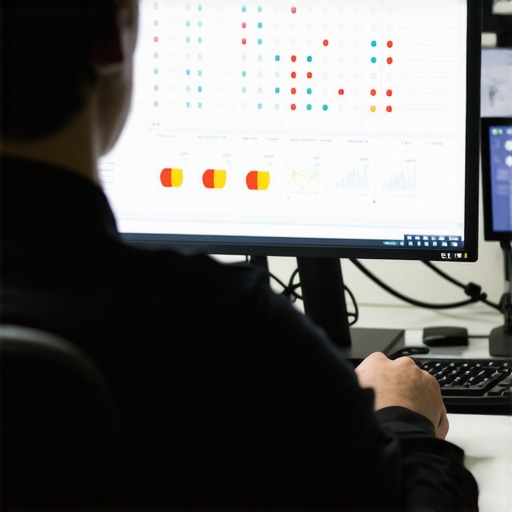

Prvi put kada sam radio na modelu za detekciju bankarskih prevara, bio sam oduševljen. Moj model je pokazivao nevjerovatnih 99,8% preciznosti (accuracy). Mislio sam da sam genije. Međutim, kada smo model pustili u testno okruženje, propustio je svaku stvarnu prevaru. Zašto? Zato što je 99,8% transakcija bilo legitimno, pa je model naučio da jednostavno sve označi kao ‘legitimno’ i tako postigne visoku statistiku bez ikakvog stvarnog učenja. To je klasična data imbalance zamka, jedna od onih kritičnih grešaka pri početku AI karijere koje vas nauče poniznosti. Ovaj vodič je tu da spriječi da napravite istu grešku.

H2: Prerequisites (The Stack)

Prije nego što krenemo u rješavanje problema disbalansa podataka, moramo postaviti našu laboratoriju. Za rad sa debalansom klase u big data okruženju, neophodni su vam specifični alati koji prevazilaze osnovni Scikit-Learn. Šta je big data i zašto je važna za AI u ovom kontekstu? Upravo zato što veći volumen podataka često donosi i ekstremnije disbalanse koji mogu sakriti manjinske klase (poput rijetkih bolesti ili finansijskih malverzacija).

- Python 3.8+: Osnova svakog modernog ML projekta.

- Pandas & NumPy: Za manipulaciju podacima i linearnu algebru.

- Imbalanced-learn (imblearn): Biblioteka koja je ‘sveti gral’ za ovaj problem. Instalira se komandom:

pip install imbalanced-learn. - Scikit-Learn: Za evaluaciju modela i osnovne algoritme.

- Matplotlib/Seaborn: Za vizualizaciju disbalansa.

H2: Under the Hood: Zašto Accuracy laže?

U mašinskom učenju, preciznost (accuracy) je metrički parametar koji mjeri broj tačnih predviđanja u odnosu na ukupan broj uzoraka. Kod balansiranih podataka, to je u redu. Međutim, kada radite sa tekstualnim podacima koristeći Šta je TF IDF i bag of words pristup, često ćete primijetiti da određene klase riječi dominiraju. Ako vaš dataset ima 1000 uzoraka, gdje je 950 klase A i 50 klase B, model koji uvijek predviđa klasu A će imati 95% preciznosti, ali će biti potpuno neupotrebljiv za klasu B.

Ovdje nastupa algoritmička diskriminacija i primeri iz stvarnog života: ako vaš model za selekciju kandidata za posao ima više podataka o jednoj demografskoj grupi, on će diskriminisati manjinu ne zato što je ‘zao’, već zato što statistički pokušava minimizirati grešku na većini. To je suština problema koji rješavamo.

[image-placeholder]

H2: The Configuration (Step-by-Step Fix)

[Visual Cue]: Otvorite vaš Jupyter Notebook i učitajte dataset. Prvo provjerite distribuciju klasa koristeći df['target'].value_counts().

Korak 1: Oversampling manjinske klase (SMOTE)

SMOTE (Synthetic Minority Over-sampling Technique) ne kopira samo postojeće podatke, već kreira nove, sintetičke primjere na osnovu k-najbližih susjeda. Ovo je ključno da izbjegnemo overfitting.

[Code/Input]:

from imblearn.over_sampling import SMOTE

sm = SMOTE(random_state=42)

X_res, y_res = sm.fit_resample(X_train, y_train)

Ovaj kod uzima vaše originalne podatke (X_train, y_train) i generiše nove uzorke tako da klase postanu 50/50 balansirane.

Korak 2: Undersampling većinske klase

Ako imate milione redova (Big Data), nekada je pametnije smanjiti većinsku klasu. Koristite RandomUnderSampler da biste ubrzali trening bez gubitka ključnih informacija.

Korak 3: Promjena metrike evaluacije

Zaboravite na Accuracy. Prebacite se na Precision-Recall Curve ili F1-Score. F1-score je harmonijska sredina preciznosti i odziva i daje realnu sliku o tome koliko je model dobar u detekciji manjinske klase.

H2: Troubleshooting & Optimizacija

Problem: Model i dalje griješi nakon SMOTE-a.

Fix: Provjerite da li ste SMOTE primijenili samo na trening setu. Ako ga primijenite na cijelom datasetu prije podjele, doći će do ‘data leakage’ efekta gdje informacije iz test seta cure u trening set, dajući vam lažnu sliku uspjeha.

Za optimizaciju, koristite BalancedRandomForestClassifier iz imblearn biblioteke. On interno balansira svako stablo odlučivanja, što je mnogo robusnije od običnog oversamplinga.

H2: Zaključak i Etika

Rješavanje disbalansa nije samo tehničko pitanje, već i etičko. Algoritmička diskriminacija i primeri u medicini ili bankarstvu pokazuju da loše balansirani podaci direktno utiču na ljudske živote. Kao inženjer, vaša je dužnost da razumijete šta je big data i zašto je važna za AI ne samo kao resurs, već kao izvor potencijalne pristrasnosti koju morate aktivno neutralisati.