Siguran rad: Kako dodati ljudski nadzor u AI procese

Zaboravi na ‘Auto-pilota’: Zašto tvoj AI sistem treba kočnicu, a ne samo gas

Prestanite vjerovati u marketinšku laž da je vještačka inteligencija sistem koji ‘jednostavno radi’ dok vi spavate na plaži. To je brutalna neistina koja će vas koštati ili novca ili obraza. Ako mislite da možete pustiti LLM (Large Language Model) da samostalno donosi odluke bez vašeg prsta na prekidaču, vi ne gradite biznis, vi gradite tempiranu bombu. Vi morate biti ti koji drže uzde. AI nije zamjena za radnika; to je moćan, ali nepredvidiv alat koji zahtijeva čvrstu ruku i stalni nadzor. U svijetu gdje AI modeli haluciniraju češće nego što političari daju prazna obećanja, ljudski nadzor je jedina stvar koja stoji između uspjeha i totalnog kolapsa sistema.

Upozorenje: Puštanje AI agenta da direktno komunicira sa bankovnim računom ili povjerljivim podacima klijenata bez ljudske verifikacije je sigurnosni ekvivalent ostavljanja upaljene let lampe u prostoriji punoj piljevine. Kad-tad će planuti.

HITL Protokol: Kako napraviti kontrolni punkt koji zapravo radi

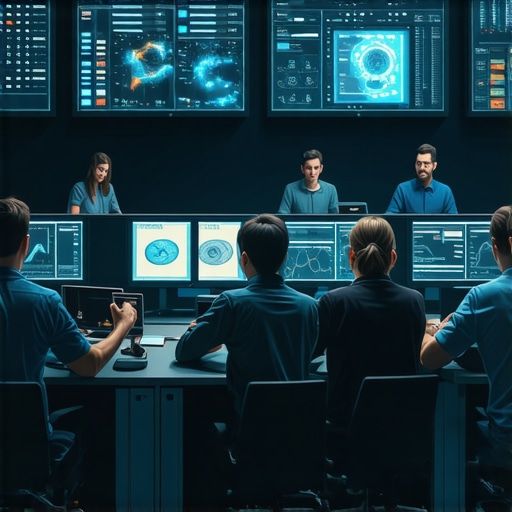

Ljudski nadzor, ili ono što mi u radionici zovemo ‘Human-in-the-Loop’ (HITL), nije samo povremeno bacanje pogleda na ekran. To je proces koji zahtijeva disciplinu. Zamislite to kao kontrolu kvaliteta kod brušenja drveta. Ako ne prođete rukom preko površine da osjetite teksturu i ‘trnce’ pod prstima, nikada nećete znati da li je posao završen kako treba. Prvi korak je postavljanje kapija za odobrenje. Svaki output koji AI generiše, a koji ima direktan uticaj na klijenta ili vašu bazu podataka, mora proći kroz ‘manualni override’. Ne smije biti direktnog izlaza bez vašeg ‘klika’.

Kada radite sa alatima kao što je praćenje performansi AI modela, morate postaviti pragove (thresholds). Ako model izbaci odgovor sa sigurnošću (confidence score) manjom od 85%, sistem mora automatski pauzirati i pozvati čovjeka. Čućete tihi zuj ventilatora dok server obrađuje podatke, ali ako taj zvuk postane previše intenzivan, to je često znak da model ‘vrti u prazno’ ili se bori sa kontradiktornim instrukcijama. To je trenutak kada vi uskačete i siječete proces.

Detekcija Halucinacija: Miris ‘spaljenog’ koda i kako ga namirisati na vrijeme

Postoji specifičan miris u zraku kada elektronika krene po zlu – onaj oštri, metalni miris ozona. Kod AI-ja nemate taj luksuz, ali imate ‘miris’ nelogičnosti. Najveća greška koju možete napraviti je da pretpostavite da je AI ‘pametniji’ od vas. Nije. On je samo brži. Da biste dodali ljudski nadzor, morate uvesti unakrsnu provjeru. Ako AI generiše kod, vi ga morate provući kroz lokalni debugger ili ga pročitati red po red. Provjerite kako provjeriti AI kod prije objave da biste izbjegli curenje podataka. Nemojte samo kopirati i lijepiti (copy-paste). To je put u propast. Svaki red koda mora biti vaš, jer vi ste ti koji će odgovarati kada se baza sruši u tri ujutro.

Zašto je bitno da razumijete ‘utege’ (Weights)?

U mašinskom učenju, utezi su ono što određuje važnost određenih informacija. Ako ne razumijete kako vaš model donosi odluke, vi ste samo putnik u automobilu bez kočnica. Jednom mjesečno, morate raditi ‘stres test’ svog sistema. Namjerno ubacite pogrešne podatke i vidite da li će vaši filteri za ljudski nadzor reagovati. Ako sistem ‘proguta’ smeće bez upozorenja, vaš nadzor je neuspješan. Morate ga prepraviti odmah. Ne sutra. Odmah.

Sigurnosna kočnica (Kill-Switch): Tvoj najvažniji alat u 2026.

Svaka ozbiljna mašina u mojoj radionici ima ono veliko crveno dugme koje prekida struju u milisekundi. Tvoj AI proces mora imati isto. Ako primijetite da vaš AI za pravne ugovore počne miješati valute ili ignorisati klauzule o privatnosti, morate imati mogućnost da ‘ubijete’ proces jednim klikom. To se ne radi ‘effortlessly’. To se radi tako što se u sam kod ugradi funkcija koja blokira API pozive čim se detektuje anomalija. To je ona sigurnost koja vam omogućava da mirno spavate.

Da li moram baš svaki odgovor provjeriti?

Odgovor je kratak: Da, ako je bitno. Ne, ako je trivijalno. Ali granicu povlačite vi, a ne AI. Uvijek koristite metodu uzorkovanja ako imate hiljade procesa. Provjerite svaki deseti, ali ga provjerite detaljno, kao da od toga zavisi vaš život. Jer u biznisu, od povjerenja klijenata i zavisi vaš opstanak.

Anatomija katastrofe: Šta se desi kada AI agent piše bez nadzora

Sjedite za stolom, kafa se hladi, a vi dobijate obavještenje da je vaš automatizovani sistem za podršku klijentima upravo obećao besplatan proizvod desetini ljudi jer su ga ‘nadmudrili’ prompt inženjeringom. To je realnost bez ljudskog nadzora. Ja sam jednom vidio kako loše podešen skript ‘pojede’ cijelu bazu podataka jer mu niko nije postavio limit za brisanje. Osjećaj mučnine u stomaku dok gledate prazne tabele je nešto što ne želite doživjeti. Zato, dodajte ljudsku verifikaciju za destruktivne akcije. Bilo kakvo brisanje, slanje novca ili promjena korisničkih prava mora zahtijevati vaš potpis. To usporava proces? Da. To vas spašava od bankrota? Apsolutno.

Zakon i etika: Ne igraj se sa tuđim podacima

U 2026. godini, zakoni o AI-ju su stroži nego ikad. Ako vaš sistem napravi grešku, sudija neće prihvatiti opravdanje ‘pa to je uradio AI’. Vi ste odgovorni. Korištenje open-source AI modela nosi svoje rizike, ali i slobodu da sami implementirate sigurnosne slojeve. Uvijek provjerite lokalne regulative. Ako radite na Balkanu, osigurajte da vaš nadzor uključuje i provjeru na algoritmičku diskriminaciju, jer modeli trenirani na stranim podacima često griješe u našem kontekstu. Ne budite lijeni. Uložite vrijeme u postavljanje sistema koji vas štiti. Ljudski nadzor nije prepreka automatizaciji; to je njena jedina garancija održivosti.