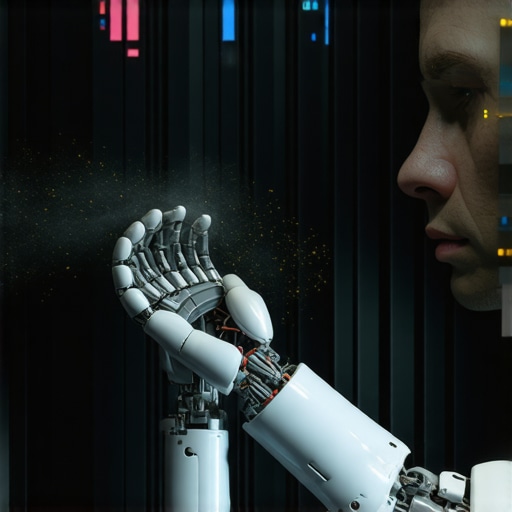

Spriječi halucinacije modela uz ljudski nadzor [Pro]

Digitalna šizofrenija: Zašto vaš model laže s osmijehom

Prestanite vjerovati marketinškim trikovima da su AI modeli ‘samokorigujući’ sistemi koji teže istini. To je opasna laž koja će vas koštati kredibiliteta, a možda i posla. Istina je surovija: LLM (Large Language Model) je statistički papagaj koji nema koncept stvarnosti. On ne zna da li je nebo plavo ili od čelika; on samo zna koja riječ statistički dolazi sljedeća. Vi, kao operater, morate biti onaj koji drži ruku na kočnici. Ako se oslonite isključivo na automatizaciju, gradite kuću na živom pijesku. Vaš posao nije samo da ‘promptate’, već da vršite forenziku svakog izlaza koji model generiše. Zaboravite na lagodan rad; kvalitetan AI zahtijeva žuljeve na mozgu i neprestanu sumnju. Human-in-the-loop nije samo termin, to je preživljavanje u digitalnom dobu.

Fizika laži: Zašto neuroni skreću s puta?

Da biste popravili halucinacije, morate razumjeti hemiju kvara. Neuralne mreže rade na principu ‘probabilističkog predviđanja’. Kada model dođe do ruba svojih trening podataka, on ne staje. On ekstrapolira. To je trenutak kada se ‘pametni’ bot pretvara u patološkog lažova. Osjetit ćete to po mirisu – ne bukvalno, već kroz tekst koji zvuči previše samouvjereno, a nema nikakvo uporište u činjenicama. To je digitalni ekvivalent napuklog betona koji je neko samo prefarbao tankim slojem boje. Ako ne znate spojiti više modela da provjeravaju jedan drugog, vi ste samo putnik u vozu koji nema mašinovođu. Halucinacija se ne dešava zbog greške u kodu, već zbog same prirode arhitekture modela koja uvijek mora dati odgovor, čak i kad ga nema.

UPOZORENJE: Nikada ne dozvolite modelu da direktno šalje podatke klijentima ili u produkciju bez ljudske validacije. 120-voltni šok za vaš biznis je ništa spram pravne tužbe zbog haluciniranog ugovora.

Protokol ‘Čelična ruka’: Postavljanje HITL barijere

Prvi korak u eliminaciji digitalnih izmišljotina je uvođenje rigoroznog protokola provjere. Zaboravite ‘Copy-Paste’ metodu. Svaka tvrdnja koju model izbaci mora proći kroz filter ‘Tri izvora’. Ako model tvrdi da je 2026. godine ROI za AI implementaciju skočio na određeni nivo, vi to provjeravate ručno. Ja sam proveo 45 minuta debugirajući jedan jedini pasus koji je zvučao savršeno, samo da bih otkrio da je referenca na zakon o autorskim pravima potpuno izmišljena. To je taj nivo detalja koji vas dijeli od amatera. Koristite AI accountability principe da mapirate svaku odluku modela. Vaš zadatak je da budete digitalni inspektor koji ne vjeruje nikome, a najmanje mašini koja nema savjest. Svaki ‘output’ je samo nacrt, nikada finalni proizvod.

Anatomija kvara: Kako jedan ‘bug’ uništava povjerenje

Zamislite scenario: koristite AI za analizu medicinskih nalaza ili finansijskih izvještaja. Model ‘halucinira’ jedan jedini decimalni zarez. Na papiru, sve izgleda uredno. Ali, šest mjeseci kasnije, sistem puca jer su podaci bili toksični od samog početka. To je ono što ja zovem ‘tihi ubica’ projekata. Ako preskočite fazu čišćenja podataka, vi zapravo kvarite model sopstvenim nemarom. Nedavno sam vidio tim koji je izgubio tri mjeseca rada jer su vjerovali botiću da će pravilno sortirati CSV tabele. Nije. Zamijenio je kolone ‘Prihod’ i ‘Rashod’ jer je naslov bio napisan kurzivom. Mašina ne razumije kontekst, ona razumije samo uzorke. Jedna mala greška pri unosu postaje katastrofa u izlazu. Budite nemilosrdni prema greškama u ranim fazama; kasnije će biti prekasno i preskupo.

Nauka o vjerovatnoći: Zašto ‘PVA ljepilo’ AI-a popušta

Razmislite o neuralnim težinama kao o PVA ljepilu. U idealnim uslovima, ono drži drvo jače od same prirode. Ali, ako je vlažnost prevelika (loši podaci) ili ako su daske loše pripremljene (loš prompt), ljepilo će postati krhko i popustiti pod pritiskom. U svijetu AI-a, to se zove ‘degradacija vjerovatnoće’. Kada model uđe u zonu niske specifičnosti, on počinje da ‘izmišlja’ veze koje ne postoje kako bi održao koherentnost rečenice. To je čista fizika informacija. Ne možete dobiti kvalitetan izlaz iz entropičnog ulaza. Zato je ključno koristiti funkcije aktivacije i razumjeti kako model ‘razmišlja’ na najnižem nivou. Ako ne razumijete zašto model bira ‘Sigmoid’ umjesto ‘ReLU’ funkcije u određenom kontekstu, vi niste majstor, vi ste samo korisnik alata koji ne razumijete.

Da li AI može potpuno prestati halucinirati?

Ne. Kratko i jasno. Dokle god se modeli baziraju na transformatorskoj arhitekturi i statističkom predviđanju, rizik od halucinacije će postojati. Vaš cilj nije nula posto halucinacija, već stopostotna detekcija istih. To zahtijeva stalni nadzor i napredne tehnike poput RAG-a (Retrieval-Augmented Generation), gdje model prisiljavate da koristi vašu bazu znanja kao jedino uporište. Ali čak i tada, čovjek mora biti taj koji će reći: ‘Ovo nema smisla’.

Koliko vremena treba posvetiti ljudskom nadzoru?

Pravilo ‘80/20’ ovdje ne važi. Ako želite [Pro] nivo rezultata, odnos mora biti 50/50. Pedeset posto vremena trošite na generisanje, a pedeset na verifikaciju i ‘fine-tuning’. Ako mislite da ćete uštedjeti vrijeme tako što ćete pustiti bota da radi sam, spremite se da trošite trostruko više vremena na popravljanje štete koju će napraviti. Kao što stari majstori kažu: ‘Dvaput mjeri, jednom sijeci’. U AI svijetu: ‘Deset puta provjeri, jednom objavi’.

Alati za digitalnu forenziku: Šta koristiti umjesto slijepe vjere

Ne oslanjajte se na jedan prozor za chat. Da biste zaustavili halucinacije, morate koristiti ‘Cross-Reference’ alate. Ja koristim Python skripte koje porede izlaze dva različita modela i markiraju diskrepance u tekstu. Ako se modeli ne slažu, to je crvena zastavica. Takođe, obavezno koristite sisteme za provjeru činjenica koji su specijalizovani za AI. Ne kupujte skupe pretplate dok ne naučite osnove ručnog debugiranja. Vaše oči su najbolji alat koji imate, ali samo ako su istrenirane da traže nedosljednosti, a ne ljepotu rečenice. AI piše lijepo, ali istina je često ružna i neuredna. Držite se činjenica, a stil ostavite za romane.

Budućnost bez laži: Integracija etike i nadzora

Na kraju dana, halucinacije su etičko pitanje. Ako pustite bota da laže, vi ste odgovorni. Odgovornost tima se ne završava klikom na ‘Submit’. Kako ulazimo u 2026. godinu, regulative postaju sve strožije. Nećete se moći opravdati rečenicom ‘to je uradio bot’. Vi ste operater. Vi ste onaj koji potpisuje rad. Zasuči rukave, otvori terminal i počni čistiti taj nered. AI je alat, moćan i opasan, poput cirkularne pile. Ako ne pazite, odsjeći će vam prste, a da i ne osjeti otpor. Budite budni, budite skeptični i nikada, ali baš nikada, ne vjerujte mašini na riječ.