Kako izbjeći opasne greške uz Responsible AI u 2026. godini

Dijagnoza katastrofe: Zašto vaš AI ‘krvari’ podatke dok vi spavate

Prestanite vjerovati u marketinšku bajku da je Responsible AI samo etička naljepnica koju zalijepite na projekt pet minuta prije lansiranja. To je laž koja će vas koštati ili licence ili obraza do 2026. godine. Ako mislite da je dovoljno instalirati par filtera na vaš chatbot i nazvati to sigurnim, varate se. Gledao sam kako sistemi padaju jer su programeri ignorisali osnovnu ‘statiku’ podataka. Vi, kao neko ko upravlja ovim alatima, morate znati da AI nije magija; to je sirova logika koja se krivi pod pritiskom loših uputa. Ako ne znate razliku između Fine-tuninga i RAG-a, vi zapravo ne gradite alat, nego tempiranu bombu u svom backendu.

Alatnica za 2026: Zašto vam treba ‘Red Teaming’ čekić, a ne samo ‘Prompt’ šminka

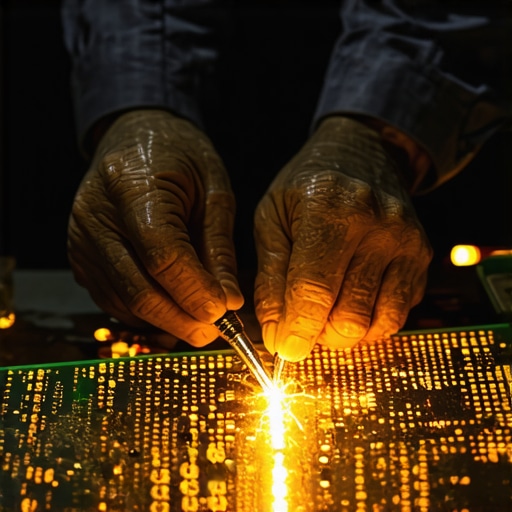

U radionici, ako vam brusilica baca varnice u lice, znate da nešto nije u redu. U AI svijetu, ‘varnice’ su tihe i zovu se prompt injection napadi. Osjetite li taj metalni ukus u ustima kada shvatite da vam je neko ‘iščupao’ bazu podataka običnom rečenicom? Treba vam specifičan set alata. Zaboravite na generičke AI asistente koji obećavaju sve. Fokusirajte se na Claude AI za teške zadatke jer on ima ugrađene sigurnosne ventile koje drugi modeli često ignorišu radi brzine. Slušajte zvuk koji vaš kod proizvodi dok se izvršava; ako predugo ‘melje’, negdje ste zaglavili u petlji loše logike.

UPOZORENJE: Dodirivanje produkcijskog koda bez prethodne validacije promptova je isto što i diranje gole žice pod naponom od 380V. Prompt injection može uzrokovati aritmiju u vašim bazama podataka i trajno kompromitovati privatnost korisnika. Testirajte svaku ulaznu tačku multimetrom logike prije puštanja u rad.

Problem ‘Data Imbalance’: Kako popraviti krivi temelj prije nego se zgrada sruši

Većina tutorijala na internetu će vam reći da samo ‘napunite’ model podacima. To je glupost. Ako gradite sistem za medicinske savjete, a vaš dataset je 90% fokusiran na jednu demografsku grupu, vaš AI će ‘halucinirati’ rješenja koja ubijaju. To se zove ‘Data Imbalance’. Iscijedio sam hiljade sati popravljajući sisteme gdje je AI davao pogrešne medicinske informacije jer su temelji bili truli. Morate koristiti fix za data imbalance greške odmah u startu. To nije opcija, to je higijena. Bez toga, vaša preciznost je samo fasada koja će puknuti pri prvom mrazu stvarne primjene.

Da li zaista trebam provjeravati svaki output modela?

Da. Kratko i jasno. Ako ostavite AI da sam odlučuje bez ‘Human-in-the-loop’ nadzora, vi ste neodgovoran majstor. Stari programer Mirza iz mog prvog tima mi je uvijek govorio: ‘Mašina ne misli, ona samo predviđa sledeći token’. Razumijevanje predviđanja sledećeg tokena je ključno da shvatite zašto AI laže sa takvim samopouzdanjem. On ne zna istinu, on zna samo statističku vjerovatnoću.

Anatomija kvara: Šta se desi kada zaboravite na pristrasnost (Bias)

Zamislite da gradite kuću i koristite libelu koja je nakrivljena za jedan stepen. Do krova, vaša kuća će biti nakaradna. Tako funkcioniše bias u AI modelima. Ako ne koristite metode za eliminaciju štetnih primjena, vaša pristrasnost će se kumulirati. Sjedio sam 12 sati čisteći jedan dataset jer je 15% podataka bilo ‘zagađeno’ starim stereotipima. To je prljav posao. Ruke će vam biti metaforički masne od lošeg koda, ali to je jedini način da izgradite nešto što traje. Koristite praktičnu evaluaciju da vidite gdje vam sistem ‘pušta’ vodu.

Zašto AI ‘halucinira’ pod pritiskom: Fizika žaljenja

Voda se širi za 9% kada se smrzne i puca čelik. AI modeli se ‘šire’ u besmislice kada dobiju upite za koje nemaju podatke. To nazivamo halucinacijama. One nisu slučajne; one su nusproizvod arhitekture. Kada LLM ne može naći put, on ga izmisli. Ako želite kvalitetne odgovore, morate savladati Beam Search algoritam. On funkcionira kao filter koji odbacuje ‘slabe’ puteve logike prije nego što izađu na ekran. Bez toga, vaša automatizacija je kao da ste pustili šegrta da sam vari nosivu konstrukciju mosta. Neće se srušiti danas, ali hoće kad prođe prvi teški kamion.

Kako prepoznati loš AI alat u 2026?

Pratite pet koraka evaluacije. Prvo, tražite transparentnost. Ako vam ne mogu objasniti kako model donosi odluke, bježite od toga. Drugo, provjerite sigurnosne sertifikate. Treće, testirajte ga na rubnim slučajevima. Četvrto, vidite koliko troši resursa. Peto, pročitajte ovaj vodič za evaluaciju. Ako alat obećava ‘magiju bez greške’, to je marketinško smeće. Dobar alat je težak, zahtijeva podešavanje i ima jasna ograničenja.

Zaključak: Majstorstvo zahtijeva disciplinu

Responsible AI nije destinacija, to je proces održavanja. Baš kao što zimi ispuštate vodu iz cijevi u vikendici da ne puknu, tako morate redovno čistiti i testirati svoje AI modele. Odbranite se od AI napada koristeći zdrav razum i provjerene strategije. Nemojte biti lijeni. U 2026. godini, razlika između uspješnog biznisa i onog koji je tužen do bankrota biće upravo u tome koliko ste ozbiljno shvatili ove ‘dosadne’ sigurnosne protokole. Zasučite rukave. Posao tek počinje.