Popravi preciznost modela: Koristi L1 i L2 tehnike [Vodič]

Prestanite kupovati priče o ‘savršenim arhitekturama’ koje se prodaju na LinkedInu. To je marketinška laž koja će tvoj model pretvoriti u prenapuhanu hrpu smeća onog trenutka kada dotakne stvarne podatke. Ako tvoj model ima 99% preciznosti na treningu, a pada na ispitu čim ga pustiš u divljinu, tvoj problem nije nedostatak podataka, već tvoja nesposobnost da kontrolišeš težine. Regularizacija nije opcija; to je sigurnosna kočnica bez koje ćeš slupati projekat. Do kraja ovog teksta znat ćeš tačno kako da koristiš L1 i L2 skalpele da odsiječeš nepotrebni šum i uštediš hiljade dolara na nepotrebnom procesiranju.

Prestanite dodavati slojeve: Mit o kompleksnosti modela

Više slojeva ne znači bolji model. To samo znači više prostora za grešku. Kada model postane previše ‘pametan’, on zapravo počne pamtiti buku u podacima umjesto da uči pravila. To se zove overfitting. Zamisli da pokušavaš napraviti stolicu od daske koja je toliko čvornovata da ti svaki put pukne dlijeto. Umjesto da kupuješ novo dlijeto, moraš naučiti kako da obradiš čvorove. Zasto ti model grijesi je lekcija koju mnogi preskoče, a onda se čude što im sistem puca pod pritiskom. Pravi majstor zna da je manje često više. Ako tvoj model ima previše slobode, on će je iskoristiti da laže tebe i tvoje klijente.

L1 Regularizacija (Lasso): Skalpel za nepotrebne ‘featurese’

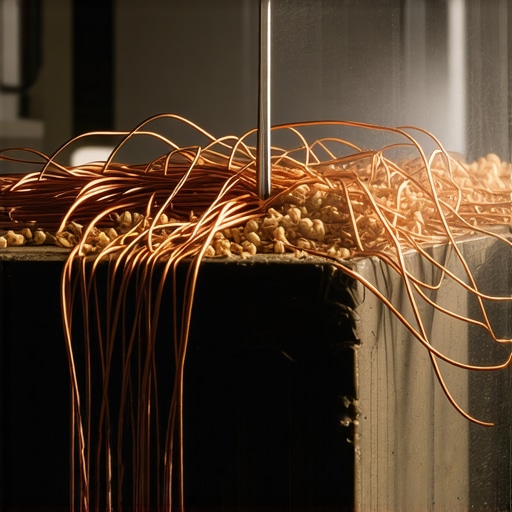

L1 regularizacija, poznata kao Lasso, radi jednu surovu stvar: ona tjera težine manje bitnih ulaza na nulu. To nije samo ‘smanjivanje’ uticaja; to je čisto brisanje. Osjetit ćete miris spaljenog koda dok Lasso prolazi kroz vaše varijable i ostavlja samo one najčvršće. To je kao da čistiš staru radionicu i bacaš sve što nisi dodirnuo dvije godine. Ako imaš 500 ulaznih podataka, a tvoj model zapravo ovisi o njih 5, L1 će te spasiti od haosa. Ali pazi, L1 je nemilosrdan. Ako mu daš preveliku slobodu, obrisat će i ono što ti treba.

UPOZORENJE: Nikada ne primjenjuj L1 regularizaciju ako prethodno nisi uradio normalizaciju podataka. Ako su tvoji podaci u različitim skalama (npr. grami i tone), L1 će ‘ubiti’ tone jer izgledaju manje, a ostaviti grame, čime ćeš potpuno uništiti logiku modela.

L2 Regularizacija (Ridge): Zatezanje labavih vijaka

Za razliku od L1, L2 (Ridge) ne briše ništa. On samo ‘zateže’. On kažnjava velike težine tako što ih smanjuje, ali ih nikada ne dovodi na nulu. Ridge je kao da dodaješ podloške na labave vijke – ništa se ne miče, ali sve ostaje povezano. Zvuk L2 regularizacije je tupi udarac čekića koji poravnava neravnine. On je idealan kada znaš da su ti svi ulazi donekle bitni, ali ne želiš da ijedan od njih dominira i stvara nestabilnost. Hyperparameter tuning ovdje igra ključnu ulogu jer moraš naći taj ‘Lambda’ balans. Previše L2 i tvoj model će biti trom; premalo i bit će krhak kao staklo.

Fizika gubitka: Zašto Lambda parametar zapravo radi

Da bismo razumjeli zašto ovo radi, moramo se vratiti na hemiju veze. Funkcija gubitka (Loss function) je tvoje mjerilo neuspjeha. Dodavanjem L1 ili L2 kazne, ti zapravo mijenjaš teren po kojem se model kreće. L1 stvara ‘oštre’ uglove (L1 norma je geometrijski kvadrat postavljen na vrh), što tjera rješenja ka osama – dakle, nuli. L2 stvara savršenu ‘kuglu’ (Euklidska norma), što omogućava težinama da se smanje ravnomjerno prema centru, ali nikada ne pogode nulu direktno. To je čista fizika optimizacije. Ako želiš stabilnost, koristi L2. Ako želiš selekciju, koristi L1. Jednostavno. Ne traži prečice.

Anatomija katastrofe: Kako uništiti model pogrešnim Lambdom

Vidio sam to stotinu puta. Junior postavi Lambdu (koeficijent regularizacije) na 10.0 jer ‘želi da bude siguran’. Rezultat? Model koji predviđa prosjek za svaki ulaz. To je kao da pokušaš popraviti sat maljem. Tvoj model postaje ‘underfitted’. Izgubi svu sposobnost učenja. S druge strane, ako postaviš Lambdu na 0.0000001, to je kao da nisi uradio ništa. Samo trošiš struju. Moraš osjetiti taj otpor. Pravi način je logaritamska skala: testiraj 0.01, 0.1, 1, 10. Testiraj svoj model stalno dok ne vidiš da se kriva validacije i kriva treninga ne počnu dodirivati. To je trenutak istine.

Zašto L1 i L2 ne rade bez normalizacije?

Ovo je najčešći razlog zašto DIY projekti u ML-u propadaju. Ako tvoji podaci nisu ‘na istoj ravni’, regularizacija je slijepa. Sredi haos u podacima prije nego što uopšte pomisliš na Lasso ili Ridge. Kao majstor, ne farbaš hrđav metal bez brušenja. Normalizacija je brušenje. Regularizacija je završni lak koji čuva sve od vanjskih uticaja. Ako preskočiš brušenje, lak će otpasti za tri dana. Ista stvar je sa težinama modela. Ne kvari rezultate glupim greškama u pripremi.

Code Reality Check: Standardi za 2026.

Prema IEEE standardima za AI sigurnost koji postaju rigorozniji u 2026. godini, modeli bez dokazane regularizacije mogli bi biti klasifikovani kao ‘nepouzdani’ u kritičnim industrijama. Nije dovoljno da model ‘radi’; moraš dokazati da nije pristrasan zbog overfittinga. Korištenje Elastic Net-a (kombinacija L1 i L2) postaje norma za ozbiljne produkcione sisteme. To je tvoj sigurnosni pojas. Ako ga ne vežeš, nemoj se žaliti kad ti revizija obori sistem. DIY pristup ne znači ‘uradi to loše’, već ‘uradi to bolje od korporativnih robota’ jer tebi je stalo do svake decimale. Redovno provjeravaj cijene procesorskog vremena – regularizovan model troši manje resursa jer je efikasniji. To je direktna ušteda u tvom džepu.