Razbij kod: Kako se objašnjava decision AI modela u praksi

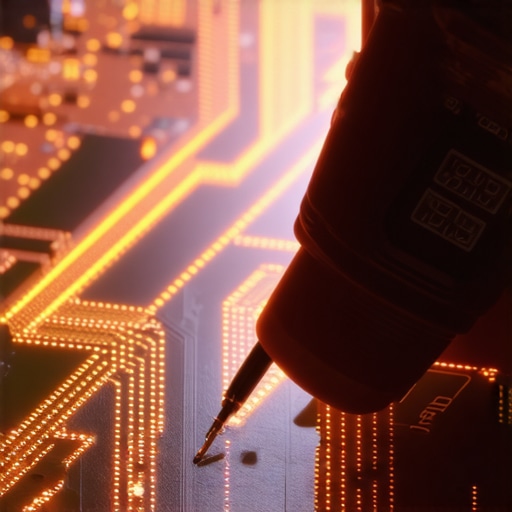

Prestanite vjerovati u marketinšku laž da je vještačka inteligencija ‘magična crna kutija’ kojoj se treba slijepo pokoravati. Ako u vašoj firmi ili radionici koristite AI modele bez razumijevanja zašto donose određene odluke, vi ne gradite budućnost; vi postavljate tempiranu bombu u svoj kod. Do 2026. godine, svako ko ne zna ‘razbiti kod’ i objasniti logiku algoritma, biće zamijenjen onima koji znaju rukovati multimetrom podataka podjednako dobro kao i pajserom.

Zaboravite na ‘osjećaj’: AI je samo gomila loše baždarenih tegova

Direktna istina: AI model ne ‘razmišlja’, on samo računa vjerovatnoću na osnovu težina koje je dodijelio vašim podacima. Ako niste znali, model može odlučiti da nekome odbije kredit samo zato što je u bazi podataka uočio piksel koji podsjeća na pogrešan poštanski broj, a ne zbog stvarnog rizika. To se zove korelacija bez kauzalnosti, i to je najbrži put do poslovne propasti. Morate shvatiti kako da decision AI modeli zapravo funkcionišu ispod haube, inače ćete trošiti sate na ispravljanje grešaka koje niste ni vidjeli da dolaze. Osjetite taj miris pregrijane logike dok pokušavate shvatiti zašto je bot juče radio, a danas izbacuje nebuloze. To je frustracija koju svaki majstor poznaje.

Alat koji vam treba: Zašto ne možete bez SHAP i LIME ‘ključeva’

Kao što ne možete otvoriti Teslin motor bez specifičnog seta bitova, tako ne možete otvoriti neuronsku mrežu bez XAI (Explainable AI) alata. SHAP (Shapley Additive Explanations) je vaš digitalni multimetar. On mjeri tačan doprinos svakog ‘šarafa’ (ulazne varijable) krajnjem rezultatu.

WARNING: Nikada ne donosite odluke o automatizaciji procesa bez prethodnog testiranja modela kroz SHAP analizu. 120v strujni udar je ništa u poređenju sa pravnim tužbama koje slijede ako vaš model diskriminiše korisnike zbog loše postavljenog ‘biasa’. Provjerite napon vaših podataka multimetrom istine.

LIME je, s druge strane, kao brza dijagnostika u pokretu. On uzme jedan mali dio koda, malo ga prodrma (perturbacije) i gleda kako se odluka mijenja. Ako promjena jedne cifre uzrokuje kolaps cijelog sistema, vaš model je krhak kao suva borovina. Donošenje odluka uz humani nadzor je jedini način da osigurate da mašina ne ‘prolupa’ u sred proizvodnog procesa.

Anatomija jednog ‘fejla’: Zašto je model mislio da je pas zapravo vuk?

Opisat ću vam jedan katastrofalan ‘screw-up’ koji se često dešava. Tim je trenirao model da razlikuje vukove od haskija. Model je imao 99% preciznosti. Nevjerovatno, zar ne? Pogrešno. Kada su upotrijebili LIME da vide šta model gleda, shvatili su da model uopšte ne gleda životinju. Gledao je snijeg u pozadini. Svaka slika vuka je imala snijeg, svaka slika haskija nije. Model je naučio da detektuje snijeg, a ne predatora. Ako preskočite ovaj korak objašnjivosti, za šest mjeseci ćete shvatiti da je vaš ‘savršeni’ sistem za retail u 2026. zapravo pratio boju poda u prodavnici, a ne ponašanje kupaca. To će vas koštati hiljade maraka bačenih na pogrešan marketing. Ne budite lijeni. Kopajte po podacima dok vas prsti ne zabole od kucanja.

Da li moram znati višu matematiku da bih objasnio AI?

Ne nužno, ali morate razumjeti logiku ‘doprinosa’. Zamislite to kao miješanje betona. Ako dodate previše vode, beton puca. SHAP vam govori tačno koliko je ‘voda’ (npr. dob korisnika) uticala na to da ‘beton’ (kreditna sposobnost) pukne. Kratko i jasno: bez metrike, vi ste samo amater koji se igra sa strujom.

Nauka o materijalima: Zašto SHAP radi (Matematika iza haosa)

Ovdje moramo stati i objasniti fiziku ovog procesa. SHAP je zasnovan na teoriji igara. Zamislite da tri radnika (ulazni podaci) grade zid. Jedan donosi cigle, drugi miješa malter, treći zida. Na kraju dana, zid je gotov. Kako pravedno podijeliti platu? SHAP izračunava doprinos svakog radnika tako što simulira gradnju zida u svim mogućim kombinacijama (sa radnikom A, bez radnika B, itd.). Ovo stvara ‘Shapley vrijednosti’ koje su jedini matematički ispravan način da se kaže: ‘Ovaj podatak je kriv za 30% odluke’. To je kao da analizirate strukturu drveta da vidite gdje će se pojaviti pukotina pod pritiskom. Razumijevanje ove ‘hemije’ podataka sprečava da vaš model postane ‘crna rupa’ koja guta budžet.

Kako samostalno baždariti AI model: Korak po korak

Prvo, nemojte kupovati skupe ‘enterprise’ alate. Koristite open-source Python biblioteke. Instalacija je prosta, ali tumačenje je tamo gdje se odvajaju majstori od šegrta. Korak 1: Učitajte svoj model. Korak 2: Generišite SHAP ‘summary plot’. Vidjećete tačkice koje vrište na vas – crvene i plave. Ako su sve nagurane na jednu stranu, vaš model je ‘pijan’ od jedne varijable. Korak 3: Pronađite ‘outliere’. To su one greške koje vas tjeraju da psujete u 3 ujutro. Sistemski rizici se kriju upravo u tim malim odstupanjima.

Koliko vremena treba za punu analizu?

Za model srednje veličine, očekujte 15 do 20 minuta procesorskog vremena. Ako traje duže, vaš kod je neoptimizovan ili koristite previše smeća od podataka. Očistite to. Jam-uj te podatke u pipeline dok ne postanu fluidni.

Fizika žaljenja: Šta se desi kad ignorišete transparentnost?

Voda se širi za 9% kada se zaledi i može razbiti čeličnu cijev. Slično tome, mala greška u logici AI modela se širi kako dodajete više korisnika. Ako u 2026. pustite algoritam da samostalno odlučuje bez ‘objašnjenja’, on će stvoriti povratnu petlju koja će uništiti vaš ROI brže nego što rđa pojede stari auspuh. Moj komšija je mislio da mu ne treba ‘XAI’ za njegovu malu firmu; danas plaća kaznu jer je njegov bot slučajno blokirao sve mailove sa ‘gmail’ domenom jer ih je označio kao ‘sistemski rizik’. Nemojte biti taj lik. Provjerite spojeve. Zategnite matice. Razbijte kod prije nego što on razbije vaš biznis.